阿里巴巴·汤伊(Alibaba Tongyi Kaiyuan)思考的音频

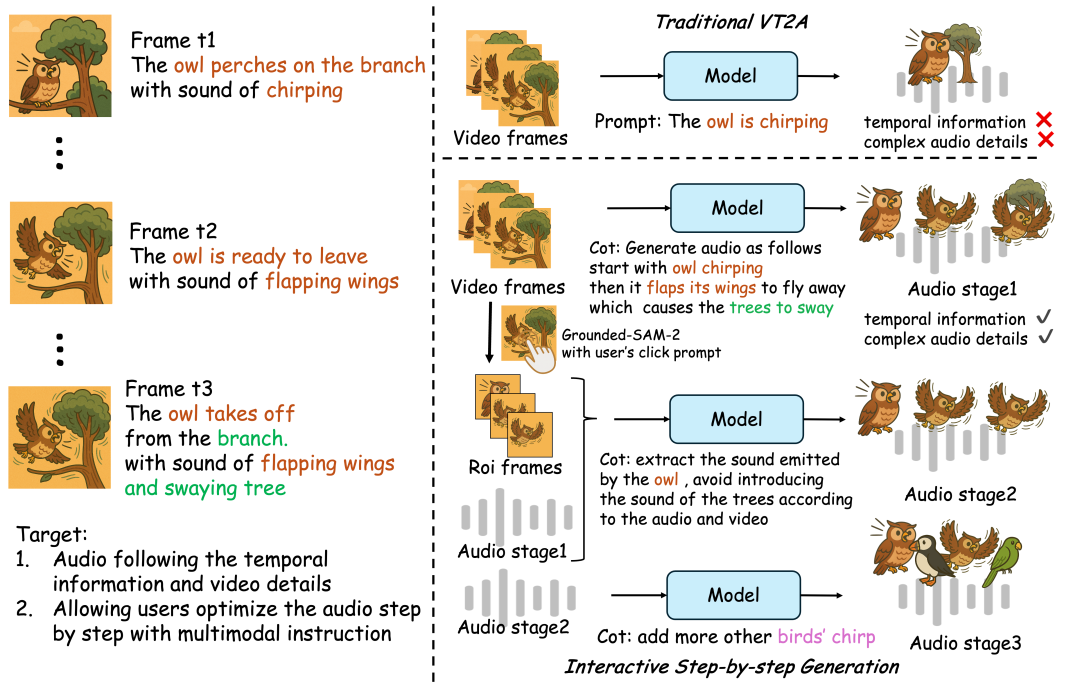

他在7月4日报道说,阿里巴巴“汤蒂大型车型”的公共说法今天宣布。汤蒂实验室的第一个音频生成模型是正式开源的,根据报道,打破了“无声图像”的想象力。 ThinkSound是第一个将COT(思维)应用于音频生成领域的人,这使AI可以学会“考虑”事件与图像的声音之间的关系,从而实现了高忠诚度和强大的同步空间音频,而不仅仅是“ See and see and Fold”的照片,还可以“理解照片”。为了帮助AI学习“逻辑上的聆听”,汤比实验室的语音团队构建了第一个多模式的音频数据集Audiocot,以承认链条的推断。 Audiocot结合了2531.8小时的高质量高质量样品,包括VGGSOUND,AUDIO GAMES,AUDIO TAPAS,FREESTUND。这些数据cuben各种各样的真实场景,提供丰富而多样的该模型的训练基础,从动物推文到机械操作和环境音效。为了确保每个数据真正接受AI的结构化推理能力,研究人员设计了一个复杂的数据检测过程,包括验证多个阶段的自动质量自动自动过滤以及对手动采样超过5%的验证,并验证了每层层的每层层,以保证数据集的一般质量。据此,Audiocot也是专门设计的对象级别样本和交互式版本的指令级别,以满足后期阶段的改进和编辑功能的需求。思考包括两个关键组成部分:在思想中突出的多模式大语言模型(MLLM),以及以“审核输出”为中心的统一音频生成模型。正是这两个模块的合作使系统可以逐步分析屏幕的内容三个阶段,最终产生精确的音频效果,重点是基于对一般景观的理解的特定对象。提出要点并响应用户的说明。官方报告显示,尽管近年来在末端到末端音频产生技术(V2A)取得了重大进展,但仍然很难真正捕获照片的动态细节和空间关系。视觉声学关联,例如猫头鹰在汇合,脱落,如果分支颤抖的摩擦等时,它们通常会被忽略,并且产生的音频在重要的视觉事件中非常普遍,这使得很难满足专业创造性场景的时间和语义连贯性的严格要求。此背后的HECENTRAL问题是,AI对图像事件没有结构化的理解,无法分析,推断和合成人类声音效应等阶段的声音。它可以在https://github.com/funaud上找到iollm/thinkSoundHttps://huggingface.co/spaces/funaudiollm/thinksoundhtpps://www.modelscope.cn/studios/iic/iic/thinksound

他在7月4日报道说,阿里巴巴“汤蒂大型车型”的公共说法今天宣布。汤蒂实验室的第一个音频生成模型是正式开源的,根据报道,打破了“无声图像”的想象力。 ThinkSound是第一个将COT(思维)应用于音频生成领域的人,这使AI可以学会“考虑”事件与图像的声音之间的关系,从而实现了高忠诚度和强大的同步空间音频,而不仅仅是“ See and see and Fold”的照片,还可以“理解照片”。为了帮助AI学习“逻辑上的聆听”,汤比实验室的语音团队构建了第一个多模式的音频数据集Audiocot,以承认链条的推断。 Audiocot结合了2531.8小时的高质量高质量样品,包括VGGSOUND,AUDIO GAMES,AUDIO TAPAS,FREESTUND。这些数据cuben各种各样的真实场景,提供丰富而多样的该模型的训练基础,从动物推文到机械操作和环境音效。为了确保每个数据真正接受AI的结构化推理能力,研究人员设计了一个复杂的数据检测过程,包括验证多个阶段的自动质量自动自动过滤以及对手动采样超过5%的验证,并验证了每层层的每层层,以保证数据集的一般质量。据此,Audiocot也是专门设计的对象级别样本和交互式版本的指令级别,以满足后期阶段的改进和编辑功能的需求。思考包括两个关键组成部分:在思想中突出的多模式大语言模型(MLLM),以及以“审核输出”为中心的统一音频生成模型。正是这两个模块的合作使系统可以逐步分析屏幕的内容三个阶段,最终产生精确的音频效果,重点是基于对一般景观的理解的特定对象。提出要点并响应用户的说明。官方报告显示,尽管近年来在末端到末端音频产生技术(V2A)取得了重大进展,但仍然很难真正捕获照片的动态细节和空间关系。视觉声学关联,例如猫头鹰在汇合,脱落,如果分支颤抖的摩擦等时,它们通常会被忽略,并且产生的音频在重要的视觉事件中非常普遍,这使得很难满足专业创造性场景的时间和语义连贯性的严格要求。此背后的HECENTRAL问题是,AI对图像事件没有结构化的理解,无法分析,推断和合成人类声音效应等阶段的声音。它可以在https://github.com/funaud上找到iollm/thinkSoundHttps://huggingface.co/spaces/funaudiollm/thinksoundhtpps://www.modelscope.cn/studios/iic/iic/thinksound 上一篇:10条必须fps排名FPS游戏的下载

下一篇:没有了

下一篇:没有了